O Facebook e a Sociedade do Controle, em 2018

Há exatos dois anos, antes eleição presidencial nos Estados Unidos de 2016, escrevi um artigo intitulado "O Facebook e a Sociedade do Controle". Me lembrei dele hoje, ao ler sobre o debate com Alex Hardiman, vice-presidente de notícias da rede social, este fim de semana no South by Southwest (SXSW 2018).

O artigo começava ressaltando o quanto, enquanto sociedade, temos aversão ao Estado totalitário. Plenamente justificável,

aliás. Mas o quanto, enquanto consumidores e cidadãos, aceitamos passivamente os princípios do totalitarismo quando exercidos pelas empresas privadas, especialmente em relação ao uso que fazem de nossos dados.

É inegável que as novas tecnologias de coleta, armazenamento e processamento de dados ajudaram a multiplicar os novos mecanismos de vigilância e controle. O poder controlador está completamente dissolvido em todos os espaços digitais, garantido pela supremacia dos algoritmos, cujo funcionamento, quase sempre, desconhecemos por completo.

Como usuários das plataformas digitais, como o Facebook, concordamos em transferir dados para elas em troca de conveniência. Os algoritmos usam os dados transferidos para determinar nossos interesses. E as empresas de publicidade pagam pelo acesso a esse conhecimento da audiência. Quanto mais tempo passamos online, mais dados são extraídos e mais correlações são feitas a partir deles.

OK. Esse modelo operacional está longe de ser exclusividade do Facebook. Todas as plataformas digitais, sem exceção, operacionalizam suas práticas de moderação de conteúdo sob uma rede complexa de regras nebulosas.

Mas no Facebook, assim como na busca do Google, há o agravante de o algoritmo funcionar também como uma espécie de editor, selecionando o que será exposto. Não é de agora que não vemos na rede social tudo o que nossos amigos publicam. Sempre foi assim. Vemos o que a máquina escolhe, de acordo com fórmulas que os administradores da rede social não revelam.

Hoje, fortalecidos por técnicas de Machine e Deep Learning, algoritmos como os do Facebook nos controlam e comandam mais e mais.

O texto de março de 2016 terminava perguntando que sociedade queremos e quais controles por parte dos algoritmos estamos dispostos a aceitar ou tolerar.

Essas mesmas perguntas voltaram a me assombrar hoje, diante de algumas falas de Alex Hardiman. Segundo ela, todos no Facebook estão "empenhados em melhorar a qualidade do que circula na rede", para que os usuários do News Feed vejam "informações confiáveis".

"Nosso objetivo é minimizar as coisas ruins e promover a qualidade no feed de notícias das pessoas", disse ela.

E foi enfática no sentido de deixar claro que a rede social está apenas começando o que pode ser uma profunda mudança no seu algoritmo, visando amplificar notícias de "fontes confiáveis". "Historicamente, nunca distinguimos os tipos de notícias. E isso era problemático. Tratar todas as notícias da mesma forma significava não ser capaz de distinguir a boa notícia do conteúdo fraudulento", afirmou.

Mas, espera aí? Como é que o Facebook vai determinar o que é uma fonte confiável? Quais serão os critérios?

A rede social já nos deu inúmeros exemplos de quão pouco criteriosa pode ser ao tratar o que considera material impróprio. O caso mais expressivo, alvo de estudos complexos, foi a imediata remoção da famosa foto "The Terror of War", de Nick Ut, que mostra uma menina vietnamita de nove anos de idade, nua, gritando, correndo pela estrada após ser atingida por napalm. A fotografia ganhou inúmeros prêmios de fotojornalismo, por retratar de modo inequívoco os horrores da guerra. Na ocasião, após dura críticas, incluindo inclusive a de reescrever a história ao censurar a imagem, o Facebook acabou voltando atrás.

No fim de fevereiro, a rede social teve que se desculpar novamente após censurar a imagem da escultura "Vênus de Willendorf", de quase 30 mil anos, considerada uma obra-prima de arte paleolítica. A imagem ilustrava um post patrocinado feito por uma ativista italiana. O Facebook alegou que sua política em matéria de publicidade não permite nem a nudez, nem a sugestão de nudez. Depois dos protestos, reconheceu que a regra não se aplica a estátuas. Nem a obras de arte, espero 😉 !

Em um artigo também recente para o site Fisrt Monday, intitulado "Digital detritus: 'Error' and the logic of opacity in social media content moderation", Sarah T. Roberts, pesquisadora e professora da Universidade da Califórnia, em Los Angeles, afirma que, nas redes sociais, o ofuscamento e o segredo trabalham juntos" para formar o que ela chama de "lógica operacional da opacidade". Na sua opinião, a falta de transparência é a regra que sustenta a avaliação do conteúdo e das imagens publicadas pelos usuários. E essa avaliação atende aos interesses econômicos da plataforma, acima de tudo.

A questão central, segundo Sarah, é "o que as plataformas querem". O conteúdo é trabalhado para responder aos desejos e valores de cada uma delas, através de práticas de controle e moderação.

No caso do Facebook, o aumento dos conteúdos pessoais no News Feed, em detrimento dos conteúdos de empresas de mídia e de marcas, já provocou um aumento no custo dos anúncios na rede, segundo a empresa de propaganda digital AdStage. O Facebook anunciou o ajuste do Feed de notícias em janeiro, mês no qual a AdStage descobriu que o CPM (custo por mil impressões de anúncios) aumentou 122% em relação ao mesmo mês do ano anterior. E pode continuar aumentando a medida que vemos menos notícias e anúncios nos nossos feeds.

Vale a pena notar que as impressões de anúncios estavam diminuindo antes de o Facebook anunciar seu ajuste de feed de notícias. O crescimento das impressões foi de apenas 4% no quarto trimestre de 2017, em relação ao mesmo período de 2016. No terceiro trimestre havia sido de 10% em relação ao terceiro trimestre de 2016.

Coincidência?

O fato é que o Facebook nos conhece mais do que nós a ele, e por um simples motivo: damos a ele amplos poderes sobre nossos dados. Seria justo pedir em troca que possamos também conhecer todos os critérios que o levarão a determinar o conteúdo de qualidade e as fontes confiáveis.

Muito embora eu ainda acredite que qualquer ação para aumentar a qualidade do conteúdo, e determinar a fonte confiável, corra o risco de apenas reforçar as famosas bolhas.

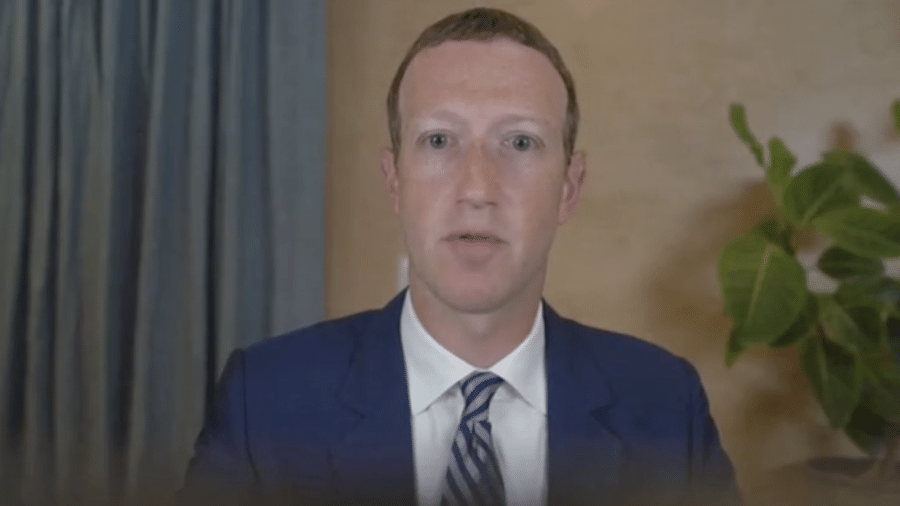

Na minha opinião, o Facebook faria mais pelos usuários, e pela própria plataforma, se tivesse regras de uso mais claras e um conhecimento mais aprofundado sobre os anunciantes, análogo ao que tem da audiência. Estou falando em ser mais criterioso sobre o que está sendo impulsionado e por quem. Mas exercer esse tipo de controle parece ser algo que não passa pela cabeça de Mark Zuckerberg, a menos que seja forçado a isso.

Na eleição deste ano, no Brasil, por exemplo, a mesma regra que permite o impulsionamento de propaganda política na rede social, determina que as plataformas devem exigir, obrigatoriamente, o CPF ou CNPJ de quem paga pelo impulsionamento da propaganda. Não é nada, não é nada, já é alguma coisa.

Além disso, o TSE prestaria um grande serviço à lisura da campanha eleitoral se agisse com presteza, junto às plataformas, para fazer valer a proibição de "veiculação de conteúdos de cunho eleitoral mediante cadastro de usuário de aplicação de internet com a intenção de falsear identidade (Lei nº 9.504/1997, art. 57-B, § 2º). Perfis falsos não deveriam ser fontes confiáveis!

Como as plataformas são obrigadas pelo TSE a manter um canal para receber denúncias de irregularidades no impulsionamento de propaganda política, esse mesmo canal poderia ser usado também para denúncias de perfis falsos. Facilitaria bastante o exercício do direito de resposta.

Vale lembrar que as regras para direito de resposta estabelecem que o ofensor deverá divulgar a resposta do ofendido em até 48 (quarenta e oito) horas após sua entrega em mídia física, empregando nessa divulgação o mesmo impulsionamento de conteúdo eventualmente contratado e o mesmo veículo, espaço, local, horário, página eletrônica, tamanho, caracteres e outros elementos de realce usados na ofensa (Lei nº 9.504/1997, art. 58, § 3º, inciso IV, alínea a).

Vou além. A essa altura, a julgar pelo ocorrido em eleições anteriores, um exército de perfis falsos já começou a ser criado com o propósito de manipular o debate e espalhar fake news. Muitos desses perfis estão relacionados à veículos de mídia fictícios. Compreender a estratégia e o modelo operacional deste exército é fundamental para essa tarefa de qualificar o conteúdo e determinar as fontes confiáveis mencionada por Alex Hardiman. O Brasil pode ser um ótimo laboratório!

ID: {{comments.info.id}}

URL: {{comments.info.url}}

Ocorreu um erro ao carregar os comentários.

Por favor, tente novamente mais tarde.

{{comments.total}} Comentário

{{comments.total}} Comentários

Seja o primeiro a comentar

Essa discussão está encerrada

Não é possivel enviar novos comentários.

Essa área é exclusiva para você, assinante, ler e comentar.

Só assinantes do UOL podem comentar

Ainda não é assinante? Assine já.

Se você já é assinante do UOL, faça seu login.

O autor da mensagem, e não o UOL, é o responsável pelo comentário. Reserve um tempo para ler as Regras de Uso para comentários.