Quem culpar quando a Inteligência Artificial falhar?

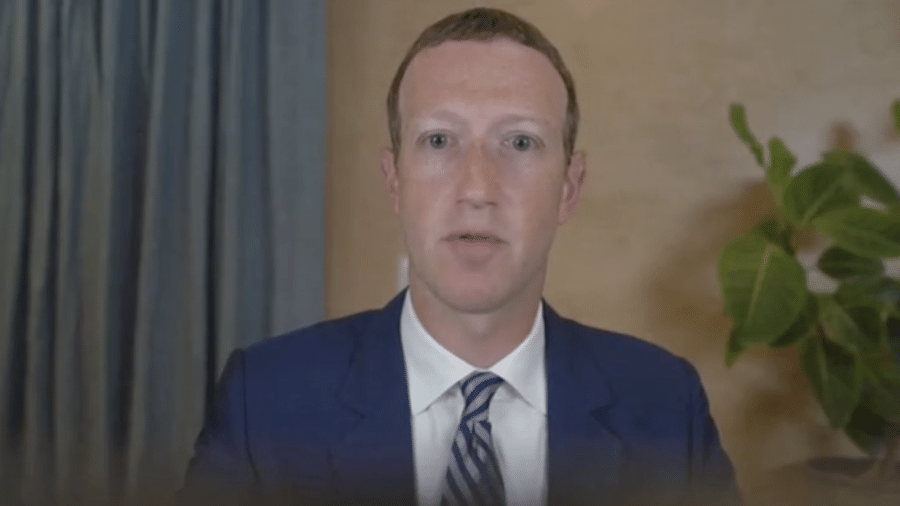

Esta semana, o Departamento de Habitação e Desenvolvimento Urbano dos Estados Unidos (HUD, na sigla em inglês) decidiu processar o Facebook por violar a Fair Housing Act, ao adotar práticas discriminatórias que, supostamente, permitiram a proprietários e corretores de imóveis excluir, sistematicamente, grupos étnicos, religiosos e minorias na segmentação de anúncios de casas e apartamentos.

"O Facebook está discriminando as pessoas com base em quem são e onde vivem", disse o secretário do HUD, Ben Carson. "Usar um computador para limitar as escolhas de moradia de uma pessoa pode ser tão discriminatório quanto bater uma porta na cara de alguém".

Executivos da rede social disseram ter ficado surpresos com a decisão e afirmaram já estarem trabalhando com o HUD para resolver suas preocupações, tomando medidas significativas para impedir a discriminação em anúncios em suas plataformas. Entre elas, criar um novo portal de publicidade para anúncios ligados a moradia e emprego que limitaria as opções de segmentação para os anunciantes.

A história podia parar aí…

Acontece, que mais do que outro escândalo ético envolvendo a rede social, a atuação do HUD foi recebida também como um sinal de alerta sobre a capacidade crescente de as empresas usarem tecnologias como a Inteligência Artificial de segmentar a oferta de produtos e serviços. Algo que já fez muito sentido, com a promessa de personalização de serviços e produtos, mas que começa a ser contestado. "Segmentar pessoas específicas inerentemente significa excluir outras pessoas", alerta Brandon Purcell, analista da Forrester.

Exemplos, nesse sentido, não faltam, como bem alertou a professora e especialista em Privacidade, Proteção de dados e Defesa do Consumidor, Laura Schertel, durante o debate "Inteligência Artificial e Ética", promovido pelo Instituto de Tecnologia e Sociedade (ITS), em São Paulo, na Estação Hack, mantida pelo Facebook Brasil nas dependência do We Work da Avenida Paulista.

Entre os muitos casos nos quais as decisões automatizadas orientadas por modelos com viés, intencionais ou não, alimentados por dados incompletos, imprecisos ou tendenciosos, podem levar a estigmatização, à discriminação e à consolidação de preconceitos, a professora Laura lembrou o de um executivo americano, negro, que teve o limite do seu cartão de crédito reduzido arbitrariamente pela administradora do cartão. Ao perguntar o motivo, a administradora alegou que ele fazia uso em locais onde o ticket médio era baixo, não necessitando portanto do valor concedido anteriormente. Ele vivia em um bairro negro e frequentava estabelecimentos da região.

É fato. Máquinas vão decidir cada vez mais sobre várias coisas no nosso quotidiano, e essas decisões vão ter consequências sobre as nossas vidas. Mas que garantias temos de que essas decisões não nos prejudicarão mais do que beneficiarão? Se essa pergunta ainda não o atormenta, recomendo ler o livro de Cathy O'Neil, Weapons of Math Destruction. É uma ótima introdução aos modelos preditivos, como eles funcionam e como eles podem se tornar tendenciosos. Ela se refere a modelos defeituosos que são opacos, escaláveis e têm o potencial de danificar vidas (frequentemente as vidas dos pobres e desfavorecidos) como as Armas de Destruição em Massa.

Apesar das boas intenções por trás do uso da Inteligência Artificial, é mais provável que ela se torne uma arma matemática sempre que não tenhamos dados suficientes para tirar conclusões confiáveis, usemos proxies para substituir dados inexistentes e tentemos usar modelos simplistas para entender e prever comportamento humano.

Pior. A maioria desses algoritmos é obscura, fazendo com que as pessoas afetadas por eles não consigam desafiar seus resultados. O texto "The Scored Society: Due Process for Automated Predictions" discute esse assunto no contexto da pontuação de crédito. Seus autores propõem a abertura do processo de pontuação à revisão pública, ao mesmo tempo em que exigem que as empresas de classificação de crédito informem os indivíduos sobre como diferentes variáveis influenciam suas pontuações.

Pior ainda. Na maioria das vezes, até mesmo os criadores não sabem exatamente por que chegaram a essas conclusões ou resultados.Não há uma maneira fácil de rastrear a lógica de um sistema de Machine Learning (um subset da Inteligência Artificial, por assim dizer). Quanto mais deixarmos a IA percorrer caminhos obscuros, mais provável será que acabemos em algum lugar que não queremos estar – e talvez não consigamos sair.

O que nos leva a algumas questões relevantes, como bem lembrou o também professor e especialista em proteção de dados Danilo Doneda, no mesmo debate do ITS. Qual será o papel da ética nesse novo cenário? E o das regulações?

No caso do Facebook, citado no início desse texto, foi fácil para o HUD agir. Afinal de contas, seus técnicos conseguiram identificar com clareza que a rede social forneceu atributos para que fossem explicitamente usados para discriminar pessoas!

Diante de todo o debate em torno da Ética da IA, Purcell foi rápido no diagnóstico: "O Facebook precisa seguir o exemplo da Salesforce, que contratou um diretor de ética e uso humano no ano passado, ou o Google, que tem uma diretoria focada na ética da IA e acaba de criar um conselho externo para monitorar a aplicação correta dos seus "Princípios para a Inteligência Artificial" , escreveu.

Mas será que é o suficiente?

Na opinião de Danilo Doneda, a ética permite uma certa flexibilidade ao tratar dessas questões. E que se possa tentar antever cenários que ainda não são concretos. Ao olharmos para o princípio do Privacy by design, por exemplo, a ética pode ser de muito mais valia que o compliance e uma eventual adequação a uma legislação, por que ela permite verificar problemas que talvez a lei ainda não enderece, ressalta o professor.

Ele lembra ainda que a ética precisa ser aplicada também ao dados, e não somente os algoritmos. "Os dados que vão alimentar esses sistemas de IA podem, por si só, conter vieses", explica.

No recrutamento e na contratação, por exemplo, a IA costuma ser usada para identificar candidatos ideais para cargos em aberto. Sem os dados adequados, a IA pode piorar os problemas de diversidade em áreas como a TI, onde já existe uma falta significativa de mulheres e minorias sub-representadas. Se a maioria dos empregados é formada por homens brancos, as chances de a IA privilegiar essas características são muito grandes, por conta da amostragem usada. "Muitos sistemas automatizados são dependentes dos dados entrados. A partir dos dados que entram, o algoritmo vai dar essa ou aquela resposta", comenta Doneda.

Da mesma forma, os algoritmos podem corromper a pureza dos dados… "Transparência e interpretação vêm em primeiro lugar, e referem-se a ser capaz de encontrar as unidades de alta influência em uma rede de Machine Learning, bem como os pesos dessas unidades e como elas mapeiam dados e saídas específicas", explica Ryan Welsh, fundador e diretor da startup de IA Kyndi, durante um painel sobre a ética da Inteligência Artificial no South by Southwest. Entender como os sistemas de IA estão interpretando os dados que recebem e ajustando os algoritmos é uma forma de resolver muitos dos problemas citados aqui.

Examinar continuamente os resultados que você recebe e olhar atentamente para os preconceitos é fundamental, acrescenta Melanie Pasch, chefe de conteúdo e gerente da Gloat.

Por exemplo, o software de recrutamento anônimo da Gloat não apenas anonimiza os currículos removendo nomes e qualquer outro fator que possa associar candidatos a sexo, raça ou etnia, mas outros fatores que podem apontar para a classe socioeconômica.

"Percebemos, observando os resultados, que certos hobbies – como andar a cavalo, por exemplo – eram um indicador inconsciente da classe socioeconômica. Também percebemos, em uma nota positiva, que para alguns papéis, os graus não estavam necessariamente correlacionados com o sucesso no trabalho, então codificamos esses fatores para removê-los da consideração e nos concentramos em outros pontos de dados ", diz ela.

Cada vez mais as organizações precisam agir como a Gloat, se conscientizar da Ética da IA, e começar a conduzir suas práticas internas para assegurar que ela está sendo implementada "by design". É muito sutil, mas é extremamente importante e excepcionalmente impactante.

Também deve haver um processo pelo qual os humanos revisem as decisões da IA para se certificar de que estão funcionando conforme planejado, e não estão exacerbando vieses, diz Pasch.

Cada vez mais, as empresas e a sociedade deverão se engajar na discussão sobre Ética na IA – sobre quando é e quando não é apropriado tratar diferentes tipos de pessoas de forma diferente usando Machine Learning e outras técnicas.

E as legislações?

Bom, se a Ética da IA tem um longo caminho pela frente, na tentativa de pactuar princípios a serem seguidos pelas empresas, as legislações têm um caminho ainda maior.

Hoje, grande parte da personalização proporcionada por algoritmos nas aplicações de Internet mais populares adota uma forma de Inteligência Artificial. A recomendação de novas músicas (de acordo com o histórico de audições), a seleção de quais postagens irão aparecer primeiro no feed de notícias de uma rede social (com base nas interações prévias) e mesmo o melhor caminho a seguir em um aplicativo de trânsito (com base nas informações sobre engarrafamentos na cidade) são aplicações de IA. A legislação não pode engessá-las, embora precise coibir abusos.

O maior desafio das legislações, nesse sentido, é responsabilização por falhas específicas da IA. Quem culpar? A empresa? Seu desenvolvedor?

O Regulamento Geral de Proteção de Dados da União Europeia (GDPR), tentou jogar alguma luz sobre essa questão incluindo entre os direitos dos titulares dos dados o "direito à explicação" de todas as decisões automatizadas feitas por sistemas de Inteligência Artificial.

Mas alguns estudiosos argumentam que, diante da inexistência de menção expressa a tal direito no texto principal do GDPR, bem como da linguagem ambígua adotada em muitos de seus artigos, o cenário é de incerteza acerca de aplicação e abrangência desse direito.

No Brasil, a Lei Geral de Proteção de Dados também tratou do "direito à explicação", de forma mais clara que o GDPR. Mas o artigo que tratava dele (o 20) foi modificado pela Medida Provisória 869/18, que cria a Autoridade Nacional de Proteção de Dados (ANPD), em análise por uma Comissão Mista do Congresso, recém instalada. A MP retirou a possibilidade de revisão de decisões algorítmicas por humanos, mas manteve a possibilidade de revisão por máquinas, tornando a medida pouco eficaz.

"Se a revisão é um direito e ela pode ser feita por meios automatizados, segundo o atual artigo 20, a revisão da decisão, em si, também será um ato automatizado que, por sua vez, será passível de pedido de revisão… Entraremos portanto em um loop infinito", comenta Danilo Doneda.

Na opinião do professor, a única revisão capaz de atender aos critérios da lei continua sendo aquela realizada por uma pessoa que seja capaz de conhecer e manejar os parâmetros que levaram à decisão automatizada e que possa explicá-los à pessoa (titular dos dados) que sofreu os efeitos da decisão.

Até aqui, portanto, tanto o GDPR quanto a LGPD, da forma como estão, talvez possam ajudar pouco, ou quase nada, no sentido da responsabilização por falhas da IA.

Vale lembrar que o HUD se valeu de regulamentos antigos para processar o Facebook. E o fez, volto a frisar, porque considera razoavelmente fácil provar a violação alegada.O Fair Housing Act proíbe a discriminação em moradia e serviços relacionados, incluindo anúncios online, com base em raça, cor, nacionalidade, religião, sexo, deficiência ou status familiar.

Mas e quando essa comprovação não for possível, até mesmo por impossibilidade de auditoria nos algoritmos e dados de treinamento?

A tomada de decisão orientada pela Inteligência Artificial já está presente no Marketing, na Advocacia, na Medicina, na Administração, no controle dos serviços públicos das Cidades Inteligentes, na condução dos veículos autônomos e por aí vai… "O Machine Learning e a criptografia criam novas camadas, muitas vezes descentralizadas, sem permissão, para observar o significado, a intenção e a preferência e para agregar valor a elas", comenta o investido Ben Evans. Estamos falando de oportunidades de uso de IA por empresas de energia e transporte, fintechs, insurtechs, healthtech, biotechs e por aí vai…

Ao menos por um tempo, as empresas precisarão se auto-regular para que a IA ajude, mais do que atrapalhe. Mas elas só o farão se nós, cidadãos/consumidores, passarmos a exigir condutas éticas no tratamento dos nossos dados, cada vez mais.

O equilíbrio entre regulação e auto-regulação da indústria dependerá de de todos nós, e também dos governos.

Os órgãos reguladores estão incomodados com o laissez-faire em torno da economia dos dados. Segundo dados do Fórum Econômico Mundial, a IA foi projetada para gerenciar US $ 1 trilhão em ativos até 2020. Como na área de saúde, nem todas as decisões financeiras podem ser tomadas apenas por lógica algorítmica. As variáveis que desempenham na gestão de um portfólio são complexas e um movimento em falso pode levar a milhões em perdas.

Meses atrás, durante durante o Congresso Internacional de Proteção de Dados, realizado em São Paulo, a Procuradora Federal Ilene Patricia de Noronha Najjarian, lotada na Comissão de Valores Mobiliários (CVM) lamentou que a LGPD não tivesse avançado mais em relação a questões como personificação, ou seja, dar personalidade jurídica à Inteligência Artificial, vinculando-a o criador do algoritmo ao aplicativo que está fazendo uso da IA. "Nós temos que ver como controlar essa Inteligência Artificial no mercado de capitais e no mercado financeiro", disse. Não só…

Não há nenhuma dúvida de que precisamos iniciar esse debate sobre ética e responsabilização o quanto antes.

ID: {{comments.info.id}}

URL: {{comments.info.url}}

Ocorreu um erro ao carregar os comentários.

Por favor, tente novamente mais tarde.

{{comments.total}} Comentário

{{comments.total}} Comentários

Seja o primeiro a comentar

Essa discussão está encerrada

Não é possivel enviar novos comentários.

Essa área é exclusiva para você, assinante, ler e comentar.

Só assinantes do UOL podem comentar

Ainda não é assinante? Assine já.

Se você já é assinante do UOL, faça seu login.

O autor da mensagem, e não o UOL, é o responsável pelo comentário. Reserve um tempo para ler as Regras de Uso para comentários.