Conselhos éticos podem realmente nos proteger do Google e do Facebook?

Esta semana começou a circular nos Estados Unidos a notícia de que a Federal Trade Commission (FTC) não irá apenas multar o Facebook. Ela pensa em impor outras sanções à rede social. Entre elas, exigir que a empresa crie um cargo executivo dedicado à privacidade nos níveis mais altos da empresa, e um comitê de ética "independente" que inclua membros do conselho do Facebook.

Ambos seriam responsáveis por garantir que o Facebook realmente revise de forma rigorosa questões de privacidade relacionadas a novos produtos e serviços antes de lançá-los. E documente suas decisões e esforços para antecipar potenciais armadilhas de privacidade, o que ajudaria a FTC a avaliar se a gigante da rede social pesou totalmente os efeitos de suas práticas de coleta de dados dos usuários. Isso inclui imputar ao Facebook um papel mais ativo quanto aos desenvolvedores de aplicativos, revendo suas ofertas e garantindo que elas obedeçam às políticas da própria rede social. Algo que, em teoria, poderia evitar uma nova Cambridge Analytica.

De onde vieram essas ideias? Do próprio Facebook, inspirado nos conselhos de ética para Inteligência Artificial, como parte do acordo em negociação com a FTC que também inclui a multa recorde de até US $ 5 bilhões.

O Facebook disse aos investigadores federais que está aberto a uma maior fiscalização de suas práticas de privacidade. Para provar sua boa vontade, estaria disposto a dar à FTC o poder de veto sobre a escolha do executivo de privacidade aprovado pelo governo federal, chamado de "assessor". E chegou até a detalhar o funcionamento do novo comitê de supervisão de privacidade, que se reunirá trimestralmente e lançará relatórios periódicos sobre as práticas de privacidade da empresa.

Mas a falta de clareza sobre questões fundamentais, como que tipo de autoridade o avaliador de privacidade terá e se o comitê de privacidade terá realmente o poder de moldar as decisões corporativas e de produto do Facebook, ou quem pagará os salários desses profissionais e que tipo de ascendência eles terão sobre o conselho de administração da empresa, bastaram para reabrir uma debate recente: tais conselhos de ética, cuidem deles da privacidade ou do perfeito funcionamento dos algoritmos de Inteligência Artificial, podem realmente nos proteger da atuação dos gigantes da tecnologia?

Seus algoritmos estão sendo responsáveis por tomar decisões que afetam nossas vidas mais do que nunca. Mas está ficando cada vez mais claro que isso nem sempre é feito de forma justa ou transparente. Em alguns casos, eles estão sendo usados para causar danos e influenciar comportamentos de maneira moralmente duvidosa.

Em teoria, os algoritmos em si não são tendenciosos; o viés, quase sempre, vem dos dados usados para treiná-los. E como o preconceito está arraigado na sociedade, seja em termos de raça, idade ou sexo, a construção de algoritmos completamente livres desses vieses não é tarefa fácil. Para evitar que mau uso se torne norma, empresas como as empresas de tecnologia decidiram criar conselhos independentes, encarregados de supervisionar suas atividades de coleta e tratamento de dados.

Os conselhos

A Microsoft, por exemplo, tem seus próprios princípios de Inteligência Artificial e fundou seu comitê de ética em 2018.

Em maio deste ano, a Amazon começou a patrocinar pesquisa sobre "justiça em inteligência artificial" com a ajuda da National Science Foundation. E em janeiro, o próprio Facebook co-fundou um centro de pesquisa em ética. Na Alemanha.

A iniciativa mais badalada, no entanto, foi a da Google. Em 26 de março, a empresa anunciou a formação de um grupo externo de consultoria para ajudá-la a navegar por questões complexas em torno do desenvolvimento ético e responsável de novas tecnologias, incluindo a Inteligência Artificial. Em 4 de abril, no entanto, o conselho foi dissolvido. A inclusão da presidente da Heritage Foundation, Kay Coles James, no grupo causou protestos por suas visões anti-ambientalistas, anti-LGBTQ e anti-imigração, e levou quase 2,5 mil funcionários do Google a assinar uma petição para sua saída. Depois disso, o Google reconheceu que a empresa precisava "voltar à prancheta", se quisesse ter um conselho respeitado até pelos próprios funcionários.

O episódio levou vários analistas a questionar a efetividade da criação dos conselhos. "Não temos ideia de se os conselhos de ética são realmente uma bússola moral ou apenas mais um carimbo de borracha", disse Director of Policy Research do AI Now Institute at NYU.

Na opinião dela, assim como de muitos outros especialistas, para que os comitês de ética ou privacidade tenham algum impacto significativo, eles devem ser publicamente responsáveis e ter autoridade real de supervisão.

"Não é que as pessoas sejam contra os órgãos de governança, mas não temos transparência sobre como eles são constituídos", disse o cientista de dados Rumman Chowdhury, líder da área de IA da Accenture, ao "The Verge".

Isso significa que as empresas de tecnologia devem estar dispostas a compartilhar os critérios usados para selecionar quem participará desses conselhos. E também ser transparentes e específicas sobre os papéis e responsabilidades desses colegiados para que o público possa avaliar sua eficácia. Dada a influência e responsabilidade global das grandes empresas de tecnologia na nossa vida, este nível de transparência e responsabilidade é essencial.

O problema

"Parte do problema é que o Vale do Silício está convencido de que pode se policiar", diz Chowdhury.

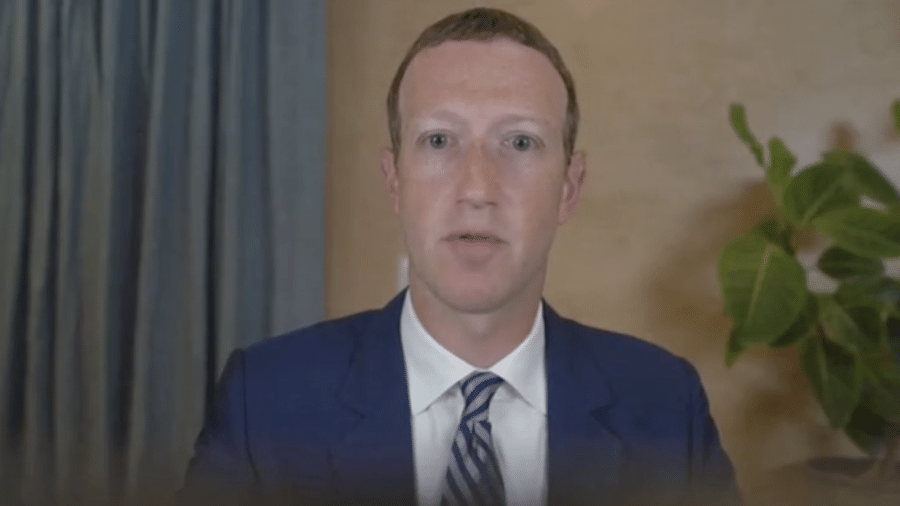

No caso do Facebook, por exemplo, o acordo proposto à FTC, conforme descrito ao site "Politico" por uma fonte próxima às negociações, não inclui novas restrições às práticas de manipulação de dados do Facebook, que os defensores da privacidade têm repetidamente solicitado. E que tanto tem preocupado as pessoas quanto aos sistemas de Inteligência Artificial. Nem exige a remoção de Zuckerberg como presidente do conselho do Facebook ou outros controles de sua liderança – outras idéias lançadas pelos críticos da empresa. Ao contrário, coloca Zuckerberg no papel de "responsável pela conformidade" e responsável pela execução das políticas de privacidade da empresa. Isso o tornaria pessoalmente responsável pelo tratamento das questões de privacidade na rede social!

Alguém acredita que possa dar certo?

"Grande parte da ingenuidade atual em torno da ética da IA, e da ética da tecnologia de forma mais ampla, surge do pressuposto de que o desenvolvimento de diretrizes éticas e de grupos consultivos [como os propostos por Google e Facebook] são suficientes para garantir a inovação socialmente responsável. Infelizmente, não são", argumenta Andrew Maynard, diretor do ASU Risk Innovation Lab.

Na pior das hipóteses, conselhos consultivos de ética (incluindo aí conselhos de privacidade) podem facilmente tornar-se uma tentativa de mascarar e espelhar os negócios, como de costume, sob o disfarce de responsabilidade social, alerta Maynard.

Na opinião dele, as empresas de tecnologia precisam de mais do que conselhos consultivos se quiserem criar produtos e serviços éticos.

Será que a FTC perceberá isso a tempo?

ID: {{comments.info.id}}

URL: {{comments.info.url}}

Ocorreu um erro ao carregar os comentários.

Por favor, tente novamente mais tarde.

{{comments.total}} Comentário

{{comments.total}} Comentários

Seja o primeiro a comentar

Essa discussão está encerrada

Não é possivel enviar novos comentários.

Essa área é exclusiva para você, assinante, ler e comentar.

Só assinantes do UOL podem comentar

Ainda não é assinante? Assine já.

Se você já é assinante do UOL, faça seu login.

O autor da mensagem, e não o UOL, é o responsável pelo comentário. Reserve um tempo para ler as Regras de Uso para comentários.